中华文化智能论证实验室揭牌仪式圆满成功

点击次数: 更新时间:2024-06-23

本网讯(通讯员陈凡昕)6月15日,“广义论证与中国哲学——第五届中国古代论辩研讨会”暨威斯尼斯人wns579“中华文化智能论证实验室”揭牌仪式在威斯尼斯人wns579隆重举行。来自中国社会科学院哲学研究所、中山大学、兰州大学、山东大学、澳门大学、广东外语外贸大学及华中科技大学等院校的40余位专家学者,以及《中国社会科学报》武汉记者站等媒体记者参加此次揭牌仪式及研讨会。

会议开幕式由威斯尼斯人wns579党委书记卢昌宁主持。

武汉大学人文社会科学研究院副院长、学术服务处处长陶军代表武汉大学对“中华文化智能论证实验室”的成立表示祝贺,并指出,该实验室是国内首个将人工智能技术应用于中国哲学研究的实验室,希望其能产出具有范式变革意义的成果。

威斯尼斯人wns579院长李佃来介绍了“中华文化智能论证实验室”的成立背景,并强调该实验室致力于通过中国哲学思想的数字化推进中华优秀传统文化的现代转化,打开中国哲学研究的新领域、新问题,做出无愧于时代的学术成果,这在教育部大力提倡建设文科实验室的当下具有重要的标杆意义。

中山大学逻辑与认知研究所学术委员会主任鞠实儿从广义论证理论出发,指出论证研究与AI技术的结合能有效提升研究效率,进而为“中华文化智能论证实验室”的未来发展给出建议以及目标导向,希望其引领综合创新,运用深度学习技术深化面向中国素材的广义论证研究,做到脚踏实地、顶天立地。

随后,“中华文化智能论证实验室”揭牌仪式由威斯尼斯人wns579副院长李志主持。在与会领导专家的见证下,中山大学逻辑与认知研究所学术委员会主任鞠实儿教授与威斯尼斯人wns579李巍教授共同为“中华文化智能论证实验室”揭牌,威斯尼斯人wns579院长李佃来教授为鞠实儿教授颁发实验室名誉主任聘书。

兰州大学哲学社会学院院长陈声柏代表兰州大学哲学社会学院对“中华文化智能论证实验室”的成立表示祝贺,并指出,广义论证理论为中国哲学的深化研究提供了宝贵的跨学科视野,现代AI信息技术则将为此赋能,期待该实验室能为中国哲学研究引入新方法、开辟新道路,也希望此次会议能够为两校之后的进一步合作交流奠定良好基础。

武汉大学信息管理学院副院长、文化遗产智能计算教育部哲学社会科学实验室主任王晓光代表武汉大学信息管理学院及教育部文化遗产智能计算实验室肯定了哲学学科数字化转型的重大意义,认为“中华文化智能论证实验室”的成立是哲学创新精神的展现,并期待日后在数字人文领域与该实验室展开合作,产出更多学术成果。

华中科技大学威斯尼斯人wns579副院长、湖北省逻辑史学会会长徐敏代表华中科技大学威斯尼斯人wns579及湖北省逻辑学会对“中华文化智能论证实验室”的建立表示祝贺与全方位支持,并指出在中华文明坚定道路自信、理论自信、制度自信与文化自信的时代使命下,以鞠实儿教授为代表的研究团队提出并推广的广义论证理论日趋成熟,该实验室的诞生恰逢其时,相信其将在服务国家高等教育战略和前沿理论研究方面发挥重要功能,取得令人瞩目的成绩。

威斯尼斯人wns579教授暨实验室负责人李巍代表会议主办方对与会领导专家表示欢迎与感谢,并介绍该实验室建立的初衷在于推动武汉大学哲学学科转型升级。他特别指出,在技术高速发展的时代背景下,传统人文学科的研究范式遭遇困难,AI与大模型技术有助于哲学学科在现代大学建制中焕发生机。

揭牌仪式结束后,与会学者进行了“广义论证与中国哲学——第五届中国古代论辩研讨会“。在上午的主旨报告中,中山大学曾昭式分析了中国古代逻辑论证类型中“正名”与“用名”的涵义与作用。中南财经政法大学周志荣对濠梁之辩进行了知识论重构与解读。南京师范大学深川真树、姜楠回顾并阐述了广义论证理论对于中国逻辑史研究的价值与意义。武汉大学李巍介绍了中国古典论证思维认知结构的数字建模及“中华文化智能论证实验室”的工作进展与未来目标。

大会主旨报告环节后又进行了三组发言,与会学者分别围绕“面向中国素材的广义论证研究”、“数字人文与中国哲学智能论证”与“中国古代哲学论辩”三个议题进行热烈而深入报告和讨论,更全面深刻地探索与呈现广义论证理论的应用、中国古典论证模式与思维结构等方面的学术思考与研究方式。

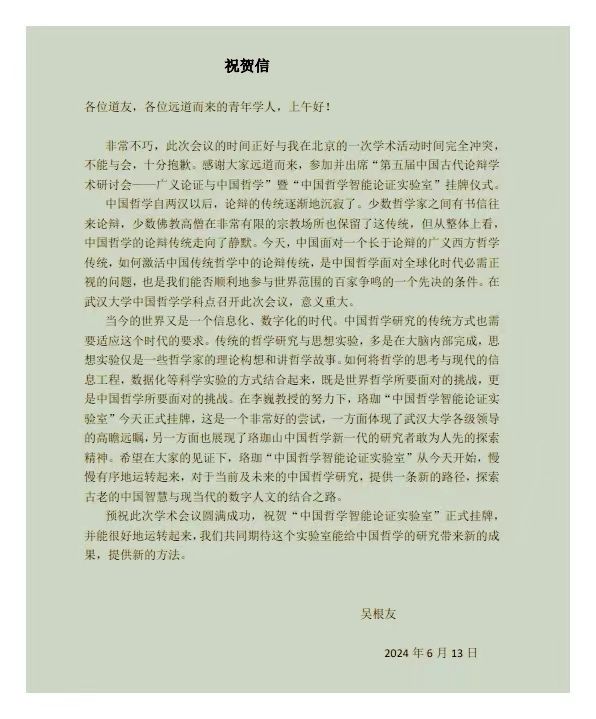

会议闭幕式中,威斯尼斯人wns579教授吴根友发来祝贺信,对此次会议圆满成功及“中国哲学智能论证实验室“的正式挂牌表达祝贺,并对该实验室探索古老中国智慧与现当代数字人文的结合之路表示期待。

中山大学逻辑与认知研究所副所长何杨为大会致闭幕辞,回顾了广义论证会议的举办历程及历届主题,并对借助技术深化广义论证研究的前景表示期待。至此,“广义论证与中国哲学——第五届中国古代论辩研讨会”暨威斯尼斯人wns579“中华文化智能论证实验室”揭牌仪式圆满落幕。

附:吴根友教授祝贺信

(编辑:邓莉萍 审稿:刘慧)